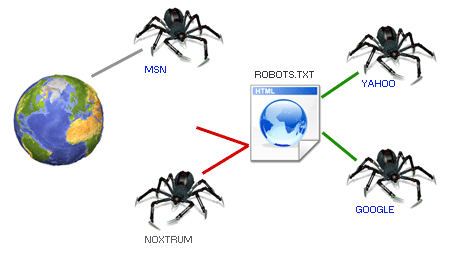

Un crawler es un robot de una entidad (generalmente buscadores) que acceden a las páginas web de un sitio para buscar información en ella, añadirla en los buscadores, etc. También son llamados spiders, arañas, bots o indexadores.

- Mediapartners-Google, que es el crawler que se encarga de revisar los anuncios de Google Adsense.

- Googlebot-Image, robot indexador de imagenes del buscador de Google.

- Bingbot, crawler de indexación del buscador Bing

- Slurp, crawler de indexación del antiguo buscador Yahoo!

- Scooter, del clásico buscador Altavista.

- Impedir acceso a robots determinados: Puede parecer contradictorio, pero algunos crawlers no nos proporcionarán sino problemas. Algunos robots no son de buscadores, e incluso algunos robots no son ni amigos. Pero de eso ya hablaremos más tarde.

- Reducir la sobrecarga del servidor: Podrás controlar el flujo de algunos robots. Algunos de ellos son un verdadero descontrol de peticiones que pueden llegar a saturar tu servidor.

- Prohibir zonas: Nos puede interesar tener disponible una zona en nuestra web, que sea accesible para algunos, pero que no aparezca en buscadores.

- Eliminar contenido duplicado: Uno de los casos más importantes, que casi siempre es olvidado por los webmasters. Si eliminamos la duplicidad de contenido, los buscadores nos puntuaran muy alto, aumentando el flujo de visitas.

- Fijar mapas del sitio: También es posible acoplar un sitemap para indicar el buen camino a los robots.